Godt Nytår! Jeg vil undlade at skrive om diverse egenskaber ved tallet 2016 – læs om dem ved at følge linket. I stedet vil jeg lade mig inspirere af Ingrid Daubechies.

Hun skrev i december et indlæg i Quanta Magazine “Big Data’s Mathematical Mysteries.” Hun beskriver forholdet mellem anvendt matematik og det, der tidligere hed “ren” matematik og nu ofte kaldes nysgerrighedsdrevet matematik. Jeg ved ikke, om jeg med dette får sagt andet og mere end Daubechies, men i matematik (og videnskab i det hele taget) har vi tradition for at “stå på kæmpernes skuldre“, så det kan jeg jo gøre.

Først lidt om Ingrid Daubechies: Hun er mest kendt som kvinden bag Wavelets – især for at have bragt wavelets fra teori til praktisk anvendelse. Wavelets bruges i signalbehandling og i komprimering af billeder og er bl.a. implementeret i JPEG2000 og til effektiv lagring af (og søgning efter) fingeraftryk i FBIs fingeraftryksdatabase. Her forklarer Arne Jensen, hvad Wavelets går ud på. Det stammer fra Numb3rsbloggen.

I Daubechies artikel citerer hun som indledning Eugenio Calabi for, at matematikere, der har en anvendelse som drivkraft (fremover kaldet anvendte matematikere) og matematikere, der er drevet af nysgerrighed (fremover kaldet rene matematikere), reagerer forskelligt, når de møder en forhindring: De rene matematikere vil indskrænke det problem, de kigger på, hvorimod de anvendte vil kigge sig om efter noget andet matematik at angribe problemet med. Noget andet værktøj.

At bringe resultater fra matematikkens indre og ud til praktisk anvendelse er ikke let. Nye områder såsom big data, kontrolteori, kvantecomputere,… har ofte behov for al den matematik, man kan kaste efter det. I den forstand, at når en fra sådan et område lærer sig noget ny matematik, så kan det meget ofte give bedre algoritmer eller ny forståelse. Når der er brug for noget nyt i en anvendelse kan man ofte finde svaret ved at tale med en fra det rette område af matematikken. Der kommer hvert år 100.000 nye matematiske artikler og matematikken er delt op i mere end 6000 underpunkter i MSC, Klassifikation af matematiske emner for eksempel er punktet Number theory delt op i 250-300 underpunkter (jeg har muligvis talt lidt forkert…). det er altså ikke let at finde den, man skal have fat i. Sommetider bliver den samme matematik så “genopdaget” i en anden sammenhæng, og der kan gå en rum tid, laves nye definitioner og beviser og skrives artikler, inden nogen opdager sammenfaldet.

Omvendt udvikles der også ny “ren” matematik med udgangspunkt i et behov fra en anvendelse. Det er ikke altid, matematikerne har den matematik klar, som skal bruges. Langt det meste af den rene matematik har sin oprindelse i anvendelserne, men det kan godt være, man har bevæget sig langt væk fra den oprindelige anvendelse. Det sker for eksempel ved, at man generaliserer/abstraherer. Fordelen er, at det på den måde bliver udkrystalliseret, hvad den underliggende struktur for problemet er. Og vupti er det klar til anvendelser i helt andre områder – hvis man da kan finde den matematik, når man skal bruge den.

Tilbage til Daubechies’ artikel. Hun skriver om “Deep Learning” – det, der i 80’erne hed neurale netværk er nu organiseret i lag, hvor output fra et lag er input til det næste – så har man deep learning – det lyder også smart. Der er andre eksempler og det falder ind under “machine learning”. Et deep learning system lærer fra eksempler og skal så kunne behandle nye tilfælde fornuftigt. Ifølge Daubechies, fungerer dette meget bedre, end matematikerne ville forvente:

Man kan tænke på, at det drejer sig om at tilnærme en funktion (et billede kan eksempelvis også betragtes som en funktion) med bedre og bedre nøjagtighed for hvert “lag” i deep learning netværket. Man ved, at det vil give en rigtig god tilnærmelse, hvis man har nok lag. (Når antallet går mod uendelig) Men det ser ud til fra de praktiske erfaringer, at man kan nøjes med meget færre lag end forventet. Man bruger et sted mellem 2 og 15-20 lag. Det er “deep”. Jeg ved, som I nok har kunnet se, ikke meget om deep learning, men det kan I nok Google jer til. Googles Brain projekt har deep learning og har her i efteråret frigivet softwaren Tensor Flow som Open Source. Så der er nok at lege med…

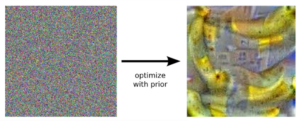

Igen fra støj til indhold. Her er netværket blevet bedt om at kigge efter bygninger i et billede, som kun er støj. Eller er det…

I juni så vi flippede billeder lavet af deep learning netværk, som blev bedt om at “forbedre” kornede billeder. Jo, de drømmer om elektriske får.

Vi har samme fænomen andre stedet i matematik, hvor et værktøj virker bedre, end forventet – man når tæt på en grænseværdi i meget færre skridt, end man kunne forvente. Og så bliver det spændende, for så er der brug for helt ny matematisk indsigt. Som så giver nyt værktøj etc.

Mit lidt forsinkede nytårsønske er, at der fortsat vil være plads til både nysgerrighedsdrevet og anvendelsesdrevet forskning i matematik.