I 2014 fandt en tysk statistiker, Thomas Royen, et bevis for en formodning fremsat i 1959. Royen skrev beviset ned og sendte det til Donald Richards, som er professor i statistik ved Pennsylvania State University. Og så bliver historien lidt mystisk: Ifølge Quanta Magazine havde Richards forsøgt at bevise formodningen i 30-40 år; han forstod, at Royens bevis var korrekt og alligevel blev den viden ikke spredt særlig effektivt. Der ser ud til at have været et hav af forkerte beviser i omløb, så måske er det druknet i det hav. Royen publicerede det i ArXiv, hvor vi allesammen lægger de næsten færdige versioner af artikler – nogenlunde samtidig med, vi sender dem til et tidsskrift. Royen valgte tidsskriftet The Far East Journal of Theoretical Statistics, et af de mange tidsskrifter med et tvivlsomt ry. Det burde nogen nok have frarådet. Men man kan da undre sig over, at det alligevel ikke blev spredt af eksempelvis Richards. Da to polske statistikere skrev en artikel, som er en gennemgang af beviset i detaljer, fik flere øje på resultatet og det er præsenteret ved Bourbakiseminar i januar i år – samme dag som Helfgott talte om grafisomorfiproblemet. Nå, men hele “human interest” historien kan I finde mange steder. Lad os se, hvad det er for en formodning.

Slår man med en terning, er sandsynligheden for en sekser . Slår man med to terninger, er sandsynligheden for, at begge giver en sekser

– produktet af de to sandsynligheder. Det bliver et produkt, fordi der ikke er nogen korrelation mellem at slå en sekser med den ene terning og at gøre det med den anden. I et tidligere blogindlæg skrev jeg om uafhængighed. To hændelser A og B er uafhængige, hvis

, altså sandsynligheden for, at både A og B sker, er produktet af sandsynlighederne for hver af dem.

Den Gaussiske korrelationsulighed siger følgende: Hvis A og B er konvekse delmængder (hvis p og q er i A, så er linjestykket mellem p og q i A) af (tænk på planen eller rummet, n=2,3) og både A og B er symmetriske omkring origo (hvis x er i A, så er -x også i A), og man skyder til måls efter en skive med centrum i origo – og pilene rammer normalfordelt omkring origo, så er

, altså at sandsynligheden for at ramme i både A og B er mindst lige så stor som produktet af de to.

En mere langhåret version siger: hvor

er det Gaussiske mål på

.

Den oprindelige version fra 1959 handler ikke umiddelbart om konvekse delmængder af planen, men om rektangler. Vi måler en række forskellige størrelser, eksempelvis højde, vægt og mellemrum mellem fortænderne. Vi ved tilfældigvis, at alle disse størrelser hver for sig er normalfordelt med middelværdi hhv. H, V og F. Vi ved nu, at 95% af alle målinger af højder falder i intervallet [H-h, H+h], 95% af alle vægtmålinger i intervallet [V-v, V+v] og mellemrum mellem fortænderne i intervallet [F-f, F+f].

Den Gaussiske korrelationsulighed siger, sandsynligheden for, at et datapunkt (x,y) (højde, vægt for en konkret person) ligger i rektanglet [H-h,H+h]x[V-v,V+v] er mindst , produktet af de to sandsynligheder. Det samme gælder (naturligvis) for (y,z), vægt og mellemrum mellem fortænderne. Sandsynligheden for, at (y,x) ligger i rektanglet [V-v,V+v]x[F-f,F+f] er mindst

. Hvis de to størrelser er uafhængige, er der lighedstegn. Eftersom en person af tæt på gennemsnitlig højde sandsynligvis også har tæt på gennemsnitlig vægt, vil vi forvente, at der ikke er lighedstegn i det første tilfælde . Mht. vægt og mellemrum mellem fortænderne, ved jeg det ikke. (Jeg havde skrevet, at noget tilsvarende gælder for kassen [H-h,H+h]x[V-v,V+v]x[F-f,F+f] – altså at et punkt ligger der med sandsynlighed

, men det er der ikke nogen, der har vist – eller påstået (tror jeg da). Og sådan kan man lære at læse det, der faktisk står i artiklen – og at spørge Svante, som fandt min fejl…)

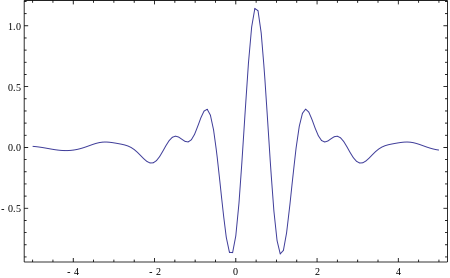

I Quanta Magazine er en fin illustration, som jeg naturligvis ikke kopierer ind her – det må man ikke… Men kig selv på den. Nedenfor er en version fra Wikipedia – tænk på højde og vægt ovenfor. Højden er den røde kurve, vægten den blå. Det samlede kan man tænke sig som en klokkeformet graf over x-y-planen, som figuren længere nede viser. Den grønne ellipse illustrerer ellipsen, det område, hvor et punkt med 99,73% sandsynlighed vil ligge. Rektanglet må I tænke jer til.

Sådan ser en Abelkage ud. Google troede, jeg mente æblekage.

Sådan ser en Abelkage ud. Google troede, jeg mente æblekage.